Nel mondo dello sviluppo del software, garantire un’erogazione fluida delle applicazioni e la loro scalabilità è fondamentale. È qui che entra in gioco DevOps, che mira a colmare il divario tra i team di sviluppo e quelli operativi. Ma anche nell’ambito di DevOps, ottenere distribuzioni senza problemi e gestire picchi di traffico inaspettati può essere una sfida.

Entra in scena l’eroe di questa storia: il bilanciatore di carico. Questa tecnologia gioca un ruolo fondamentale nella creazione di un ambiente DevOps solido ed efficiente. Scopriamo come bilanciatori di carico e perché sono essenziali per un flusso di lavoro DevOps ben oliato.

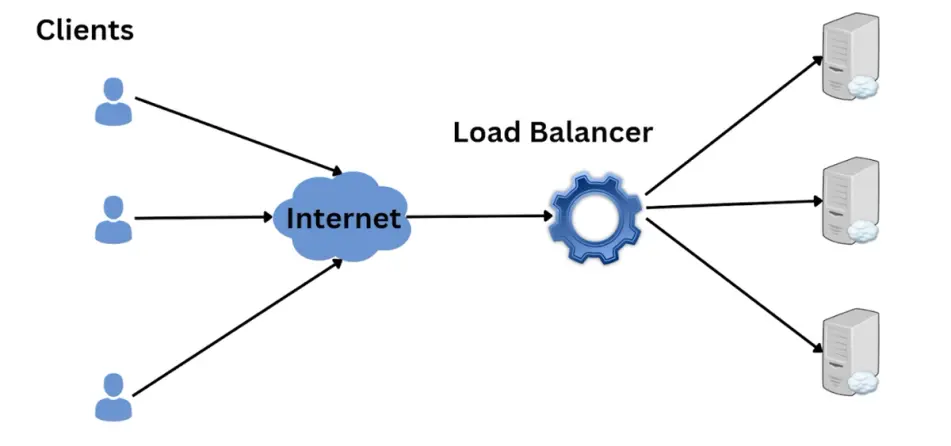

Capire i bilanciatori di carico: Il poliziotto del traffico

Un bilanciatore di carico agisce proprio come un vigile urbano, sedendosi di fronte ai server delle applicazioni e dirigendo il traffico in entrata verso i server. Quando un utente richiede l’accesso al tuo sito web o alla tua applicazione, il bilanciatore di carico riceve la richiesta. Quindi distribuisce il traffico su più server della tua infrastruttura, assicurando che nessun singolo server venga sovraccaricato.

Questa distribuzione può basarsi su vari fattori, come lo stato di salute del server, la potenza di elaborazione o anche il tipo di richiesta. L’obiettivo è quello di ottimizzare le prestazioni e garantire un’esperienza utente senza interruzioni.

Vantaggi dei Load Balancer in DevOps

Ora che abbiamo compreso le funzionalità di base dei bilanciatori di carico, analizziamo come migliorano nello specifico l’ambiente DevOps:

- Distribuzioni automatiche: Immagina di distribuire una nuova versione della tua applicazione. Tradizionalmente, potresti spegnere i server uno per uno, aggiornarli e riportarli online. Questo processo può richiedere molto tempo e creare problemi. Con un bilanciatore di carico puoi automatizzare le distribuzioni. Il bilanciatore di carico indirizza il traffico lontano dai server in fase di aggiornamento, riducendo al minimo i tempi di inattività e garantendo un rollout senza intoppi.

- Scalabilità semplificata: Quando la tua applicazione cresce di popolarità, i picchi di traffico possono diventare un vero problema. Aggiungere manualmente i server per gestire l’aumento del carico è complicato. Con un bilanciatore di carico, la scalabilità diventa semplice. Puoi aggiungere facilmente nuovi server alla tua infrastruttura. Il bilanciatore di carico rileva automaticamente i nuovi server e inizia a distribuire il traffico di conseguenza.

- Alta disponibilità: Immagina uno scenario in cui uno dei tuoi server applicativi si blocca. Con una configurazione tradizionale, l’intera applicazione potrebbe andare in tilt. Tuttavia, un bilanciatore di carico agisce come un unico punto di accesso. Se un server si guasta, il bilanciatore di carico reindirizza automaticamente il traffico verso i restanti server sani, assicurando che la tua applicazione rimanga disponibile per gli utenti.

- Miglioramento dell’utilizzo delle risorse: I bilanciatori di carico forniscono informazioni preziose sulle prestazioni dei server e sull’utilizzo delle risorse. Questi dati aiutano i team DevOps a identificare i potenziali colli di bottiglia e a ottimizzare efficacemente l’infrastruttura. Utilizzando le risorse in modo più efficiente, puoi potenzialmente risparmiare sui costi e garantire al contempo prestazioni ottimali delle applicazioni.

- Disaster Recovery semplificato: I bilanciatori di carico possono essere configurati per lavorare con più data center o ambienti cloud. In caso di interruzione del servizio in una sede, il bilanciatore di carico può instradare il traffico verso la sede di backup, riducendo al minimo i tempi di inattività e la perdita di dati.

Diversi tipi di bilanciatori di carico

Esistono due tipi principali di bilanciatori di carico comunemente utilizzati negli ambienti DevOps:

- Load Balancer di livello 4: Questi operano al livello di rete (Layer 4) del modello OSI. Distribuiscono il traffico principalmente in base a fattori come gli indirizzi IP e le porte. I bilanciatori di carico di livello 4 sono efficienti e ideali per gli scenari di traffico ad alto volume.

- Load Balancer di livello 7: Questi operano a livello di applicazione (livello 7) del modello OSI. Possono prendere decisioni più intelligenti sulla distribuzione del traffico in base a fattori come URL, tipo di contenuto e persino cookie dell’utente. I bilanciatori di carico di livello 7 offrono un controllo più granulare ma possono avere un overhead di elaborazione leggermente superiore.

La scelta tra questi tipi dipende dai requisiti specifici della tua applicazione e dai modelli di traffico.

Integrare i bilanciatori di carico nel flusso di lavoro DevOps

Ecco alcune considerazioni chiave per integrare perfettamente i bilanciatori di carico nel tuo flusso di lavoro DevOps:

- Infrastruttura come codice (IaC): Utilizza strumenti di IaC come Terraform o Ansible per automatizzare il provisioning e la configurazione del bilanciatore di carico e dei server applicativi. In questo modo si garantisce la coerenza e si riducono gli errori di configurazione manuale.

- Monitoraggio e avvisi: Imposta strumenti di monitoraggio per tenere traccia delle prestazioni del load balancer e dei server applicativi. Implementa degli avvisi per avvisare il tuo team in caso di problemi come guasti al server o colli di bottiglia nelle prestazioni.

- Integrazione della pipeline CI/CD: Integra la configurazione del bilanciatore di carico nella tua pipeline CI/CD. Questo ti permette di configurare e aggiornare automaticamente il bilanciatore di carico come parte del processo di distribuzione dell’applicazione.

Sfruttando i bilanciatori di carico, i team DevOps possono ottenere distribuzioni automatizzate, scalabilità senza sforzo, alta disponibilità e utilizzo ottimizzato delle risorse. Tutto ciò si traduce in un’erogazione più fluida delle applicazioni, in un’infrastruttura più resiliente e, in ultima analisi, in un’esperienza utente più felice.

Oltre le basi: Tecniche avanzate di bilanciamento del carico

Sebbene abbiamo trattato le funzionalità principali dei bilanciatori di carico, c’è molto altro da esplorare per chi vuole ottimizzare ulteriormente il proprio ambiente DevOps:

- Controlli sanitari: Configura il tuo bilanciatore di carico per eseguire controlli regolari sullo stato di salute dei tuoi server applicativi. In questo modo si assicura che solo i server sani ricevano il traffico, evitando che gli utenti incontrino errori dovuti a server malfunzionanti.

- Persistenza della sessione: Alcune applicazioni richiedono agli utenti di mantenere una sessione per tutta la durata della loro interazione. I bilanciatori di carico offrono funzioni di persistenza della sessione che garantiscono che gli utenti rimangano connessi allo stesso server durante la loro sessione, anche se il bilanciatore di carico li distribuisce su server diversi per altre richieste.

- Terminazione SSL/TLS: I bilanciatori di carico possono gestire la crittografia e la decrittografia SSL/TLS, scaricando questo compito dai tuoi server applicativi e migliorando le prestazioni complessive.

- Tecniche di routing avanzate: I moderni bilanciatori di carico offrono tecniche di routing avanzate come il routing basato sui contenuti o il routing basato sui percorsi, che ti permettono di avere un maggiore controllo sulla distribuzione del traffico.

Esplorando queste funzioni avanzate, i team DevOps possono migliorare ulteriormente l’efficienza della loro infrastruttura e l’esperienza degli utenti.

L’ultima parola: Abbracciare i bilanciatori di carico per un ambiente DevOps solido

I bilanciatori di carico sono uno strumento essenziale nella cassetta degli attrezzi di DevOps. La loro capacità di automatizzare le implementazioni, semplificare la scalabilità e garantire l’alta disponibilità snellisce il processo di gestione del ciclo di vita delle applicazioni. Integrando i bilanciatori di carico in modo efficace, i team DevOps possono ottenere un’infrastruttura più affidabile e scalabile, offrendo in definitiva un’esperienza utente superiore.

Quindi, la prossima volta che pensi a DevOps, ricorda l’eroe non celebrato: il bilanciatore di carico. Svolge un ruolo cruciale nel garantire che le tue applicazioni funzionino in modo fluido ed efficiente, permettendoti di concentrarti su ciò che conta di più: costruire e distribuire un software eccezionale.